Nutanix CE よろず相談所が長くなってきた&Nutanix CE 2.0 がリリースされたいい機会なので、こちらに移行したいと思います。

- Community

- International Forums

- 日本語フォーラム (Japanese)

- Nutanix CE 2.0 よろず相談所

Nutanix CE 2.0 よろず相談所

- March 2, 2023

- 90 replies

- 12454 views

90 replies

- February 9, 2024

現在、社内のサーバにNutanix CEをiLO経由(iLOのコンソール画面でCD/DVDをマウントできるので、そこからローカルにあるNutanix CEのISOファイルをマウント)で取り込み、起動を行っておりますが、途中で止まってしまいます。

止まってしまう箇所は下記となります。

INFO Getting AOS Version from /mnt/iso/images/svm/nutanix_installer_package.tar.p00, This may take a few minites if Phoenix is running from BMC

BMC経由だと数分間時間がかかるとメッセージには出ておりますが、2時間以上経過してもこのままです。解決策をご教授していただきたいです。

備考:現在、このサーバには商用版のAOS 5.x(ライセンスは既に切れているので未使用)が入っているので、一度このクラスタを削除する必要があるのかなと思っております。

こちら、解決しました。

私も類似したトラブルでインストールが行えておりません。実施した解決策をご教示いただけますでしょうか。

Dell サーバにiDrac経由で仮想メディアをマウントしてインストールしているのですが、以下のエラーでinstallが終了している状況です。

INFO Getting AOS Version from /mnt/iso/images/svm/nutanix_installer_package.tar.p00, This may take a few minites if Phoenix is running from BMC

cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p00: Input/output error

cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p01: Input/output error

/root/phoenix/images.py の123行目で以下を実行したタイミングでのエラーかと推測しております。

shell.shell_cmd([combine_command], ttyout=True)

# ここで実行している combine_command = cat /mnt/iso/images/svm/nutanix_installer_package.tar.p0* > /mnt/svm_installer/nos.tar

試しに、上記のコマンドをssh後にホスト上で実行してみる、同様のエラーとなりました。

# cat /mnt/iso/images/svm/nutanix_installer_package.tar.p0* > /mnt/svm_installer/nos.tar cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p00: Input/output error cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p01: Input/output error

また、その際のdmesgは以下のようになっています。

# dmesg | tail [ 5117.728842] Buffer I/O error on dev sr0, logical block 1, async page read [ 5117.859332] sr 11:0:0:0: [sr0] tag#0 UNKNOWN(0x2003) Result: hostbyte=0x00 driverbyte=0x08 cmd_age=0s [ 5117.859338] sr 11:0:0:0: [sr0] tag#0 Sense Key : 0x3 [current] [ 5117.859341] sr 11:0:0:0: [sr0] tag#0 ASC=0x11 ASCQ=0x0 [ 5117.859345] sr 11:0:0:0: [sr0] tag#0 CDB: opcode=0x28 28 00 00 00 00 00 00 00 02 00 [ 5117.859348] blk_update_request: critical medium error, dev sr0, sector 0 op 0x0:(READ) flags 0x0 phys_seg 2 prio class 0 [ 5117.859351] Buffer I/O error on dev sr0, logical block 0, async page read [ 5117.859354] Buffer I/O error on dev sr0, logical block 1, async page read [ 5128.216320] VFS: busy inodes on changed media sr0

以上、よろしくお願いいたします。

こちらですが、結局のところ、NWの帯域不足が原因でした。

失敗時:300GBまで帯域制限されている環境。且つ,Wi-Fi経由で通信不安定。

成功時:1GB帯域。全て有線。

- Adventurer

- February 9, 2024

私の環境も自宅からVPN経由でiDRACにアクセスしているので、安定した通信環境ではありません。

NW環境見直す or USBでインストールを試してみたいと思います。

- February 9, 2024

私の環境も自宅からVPN経由でiDRACにアクセスしているので、安定した通信環境ではありません。

NW環境見直す or USBでインストールを試してみたいと思います。

VPN経由の場合、個人でWAN帯域を食いつぶさないように帯域制限かけらているはずですので、イメージのインストール失敗の原因となっていると考えられます。通信経路が全て1GB~であればおそらく問題ないはずです。USB指せるならば一番手っ取り早いです。

- Author

- Nutanix Employee

- February 9, 2024

先日はありがとうございました。

私自身が当たったことない事象のためぱっと思いつく解決策がないく恐縮なのですが…たとえば英語フォーラムの下記こちら(https://next.nutanix.com/discussion-forum-14/trying-to-create-and-start-a-single-node-cluster-in-ce2-critical-mainthread-cluster-1430-cluster-initialization-on-x-x-x-x-failed-with-ret-false-42552/index2.html)のトピックだと、ディスクのシリアルが同一のものとして認識されてしまったことが原因で、似たような事象が発生していたようです。こちら該当してはいないでしょうか?

商用だとこういったことが起きないHWモデル/ファームウェアが必ず選定されるのですが、CEでこういった性質のHWに当たってしまうと”重複しているものを物理的に取り外す”という対応をとらざるを得ないかもしれません…。

- Adventurer

- February 26, 2024

お世話になっております。

CE2.0上に構築したPrism CentralからKarbonを利用して、k8sクラスター構築を試しています。

Storage class設定後 Createをクリックすると、「name in body should be at most 40 chars long」のエラーが表示され構築が行えません。

設定した各項目の中で40字を超えるものはないのは確認済みです。(各nameの総字数は40字を超えています)

以下のページに関連しそうなリンクがあるのですが、現在は404で閲覧ができませんでした。

https://next.nutanix.com/how-it-works-22/new-kb-articles-published-on-week-ending-may-29-2021-39622

情報をお持ちの方がいれば、ご教示いただけると幸いです。

- Trailblazer

- March 13, 2024

お世話になっております。下記の件、何か解決方法がありますでしょうか?

・クラスター構成(NutanixCE2.0):

AHVを備えた 3つのノード (A、B、C)

ノード A

ノード B

ノード C に障害があります

・実行した手順:

「クラスターの拡張」新しいオプションを使用して、ノード C と同じハードウェア構成を持つ AHV をノード (ノード D) として、クラスタに追加しました。 ノード D の追加プロセスが成功しました

。 (通知と進行状況モニターで確認されました)。

ノード D がクラスター プリズム ダッシュボードに表示されます。

・問題:

クラスター Prism から「ホストの削除」を実施して、障害のあるノード C を削除しようとすると、エラーメッセージ「ノードを削除対象としてマークできません

。「ノード 20261765 はクラスターに追加されています」が表示されて、

ノード C が削除できません。ノード D はまだクラスターに追加されているとのエラーメッセージです。

CLI経由でノードCを強制的に削除しようとしましたが、同じエラーが表示されて、うまくいきませんでした。

- Author

- Nutanix Employee

- March 17, 2024

私自身が経験したことのあるエラーではないため回答できていなかったのですが、たとえばLCMでNKE(Karbon)のバージョンを上げてからデプロイしていただくと解消する可能性はあるかと思います。

あるいは、40文字以下となっていますが、NKE(Karbon)クラスタ名をさらに短くしてみる、というのはひとつの手かと思います(社内で情報を見ていたところ17文字以下にすれば通るかもしれないという話を見かけました)。

- Author

- Nutanix Employee

- March 17, 2024

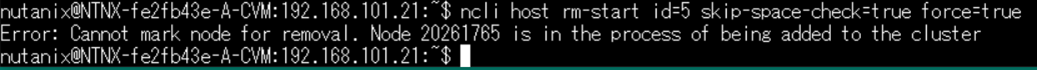

> CLI経由でノードCを強制的に削除しようとしましたが、同じエラーが表示されて、うまくいきませんでした。

については KB-2379 にあるような ncli host rm-start コマンドをお使いでしょうか?

あるいは、コマンドリファレンスにあるようなforceオプションも付けても実行されない状況でしょうか。もしまだでしたらお試し頂くことで解消される可能性はあるかと思います。(とはいえリスクのあるオプションではあるため、悪影響の出る可能性も踏まえ自己責任でという点は何卒ご了承ください…)

- Trailblazer

- March 18, 2024

お世話になっております。ご返事いただき、ありがとうございます。

> KB-2379 にあるような ncli host rm-start コマンドをお使いでしょうか?

はい、ncli host rm-start コマンドでforceオプションを付けても同じエラーが出たため、削除できません。

- Author

- Nutanix Employee

- March 18, 2024

参考までにncliコマンドのエラーメッセージの全文を(元の英文そのまま)を貼り付けていただくことは可能でしょうか?(スクショでも構いません)

有力情報を必ずしもご提供できるとは限らないのですが、社内で検索を掛けてみようと思っています。

(なにも有力情報が無かった場合は何卒ご容赦ください…)

- Trailblazer

- March 18, 2024

お世話になっております。

>参考までにncliコマンドのエラーメッセージの全文を(元の英文そのまま)を貼り付けていただくことは可能でしょうか?(スクショでも構いません)

下記画像をご確認ください。エラーメッセージ本文にある「20261765」はノードDのidです。

お手数をおかけしますが、よろしくお願いいたします。

- Author

- Nutanix Employee

- March 18, 2024

正直まだ「これだ」という答えにはたどり着けていないのですが、状態としては↓と同じような状況でしょうか(新しいノードがMetadata Ringに参加できていない)。

https://next.nutanix.com/discussion-forum-14/nutanix-ce-expand-cluster-stuck-42646

ディスクの利用率が高くない状況であれば、いったんノードCのHWを直してから1ノードクラスタとしてセットアップして、そちらにAsync DRでゲストVMを逃がしてから、A,B,Dでクラスタを組み直す、といったやり方がいちばんクリーンかもしれません。

- Trailblazer

- March 19, 2024

お世話になっております。ご確認いただき、ありがとうございます。

新しいノード(ノードD)がMatadata Ringに参加できていないとのことについて、

コマンド「ncli host ls」でノードDのHost StatusがNEWであることが確認できました。

また、ノードDをMatadata Ringに参加させるコマンド「ncli host enable-metadata-store id=20261765」を実行したら、

Error: Host ad1ddd3c-7f73-49c0-9159-83d1da82c841 is not in a ready state to enable metadata store」が

表示されて、参加できません。

上記のような状況だと、ご教授いただいた方法のようにクラスタを組み直すしかないとの認識でよろしいでしょうか?

- Trailblazer

- June 8, 2024

お世話になっております。keroro9です。

仕事のほうで、Nutanixを触る機会が今後増えそうということでNutanix熱が再燃してきました。

ヤフオクに張り付き、下記の構成で考えております。※あくまでデモ用途です。

◇構成

DL360 gen9*3ノード

#1 128GB mem、12C24T*2=24C48T CPU

#2 128GB mem、12C24T*2=24C48T CPU

#3 64GB mem 6C6T CPU

各ノード、ディスクは同条件で実装予定。

Intel DC 400GB*2+15k SAS 600G*2 =4disk/nodeで考えてます。

◇ご質問

#1,2はおそらくほぼ同条件で構成できそうです。しかし、

#3ノードのみ調達の問題でスペック・メモリ量が少なくなります。

RF2で構築することを考えています。1ノードDownを考えるとメモリだけでも同容量でそろえたほうがよいでしょうか。#3にはPrismCentral専用かなあ。。。と考えております。

アドバイスいただけますと幸甚です。

- Author

- Nutanix Employee

- June 8, 2024

デモ用環境とのことなので、HAリソースを確実に…とかを考える必要がなければ3台のスペックを均一に揃えなくても大丈夫です。

高スペックが2台あるので楽しめそうですね…!

- Trailblazer

- June 8, 2024

smzksts 様

keroro9です。早々のお返事ありがとうございます。

>高スペックが2台あるので楽しめそうですね…!

はい、久々にニヤついております(笑)

iLOからログインし状況を確認していたところ、3台ともCPUも絶妙に異なっており、同環境にそろえるにはさらなる投資が必要...ちょっと無理かな~と思っていたところでしたので、情報ありがとうございます。とりあえず行けそうとわかりましたので、追加の散財はやめておきます。

(正確には14C28T*2、12C24T*2、6C6T*1の3台でした。14コアCPUはE5-2690 v4なのですが爆熱でファンがうるさいです。)

VMに関しては高スペックノードに作ればよく、各ノード96GB程度は確保できるかなあと思っているところです。足りなければ192GB程度まで増設を検討してます。

メモリ・CPUは適当な一方、クラスタ破壊テストをやりたいという観点でデータのみRF2を維持したく、データだけ偏りがないように同条件のディスクで考えておりました。つまり、#3はRF2を維持するだけのためのノードという感じになります。ついでになにか管理系のVMをデプロイするか。くらいのノリです。(この辺の認識間違っておりましたらご指摘くださいませ。)

ちょうど先ほどの書き込みを行ったあたりで待っていたサーバが到着しました。

ボーナス月ですし楽しんでいこうかと思います。

- Author

- Nutanix Employee

- June 10, 2024

3ノード構成の場合、ゲストVMの起動時や稼働中に、負荷状況や空きリソースを見てAHVのADS(VMwareでいうDRS的な機能)が配置先を自動で決定するので、管理系のモノも、大きいノードで稼働した状態になるかもしれません。とはいえあまり細かいことを気にせずに済むのがAHVの良さなので、ホストアフィニティ等で稼働場所を縛ってしまうよりも自動制御にお任せしてしまえばいいかな、と思っています(※本番環境だと上で動かすソフトのライセンス絡みでホストアフィニティで縛ったりもしますが)。

CE環境をお楽しみ頂く上でのオススメとして、CEはブートデバイスの故障やソフトウェアアップグレードに失敗してしまった場合の回復が難しいところがあるので、データを失いたくないゲストVMがある場合にはHYCUなどのバックアップソリューションでクラスタ外に逃がしておくとを宜しいかと思います。

(※ちなみに、なぜHYCU名指しかというと、HYCUはNutanix CE環境でのライセンス無しでの利用が公式に認められている(ユーザーガイドに明記)からです。神。)

- Trailblazer

- June 16, 2024

smzksts 様

お世話になっております。通知を見逃しておりお返事が遅々としてできず。

私も風呂に入りながら似たようなことを考えており、まあロマンだなあロマン。と割り切ってしまいました(笑)。以前sandy-ep世代で試したときはPrismの画面遷移が遅くひいひい言っていましたが、さすが第4世代のXeonですのでまともに動きます。

もしご存じでしたら、下記教えていただけませんでしょうか。

NICの調整について、

https://infraapp.blogspot.com/2020/12/ahv.html

を参考にしています。というのも、先日某所で投げ売りしていたArubaの10Gスイッチの在庫が引き当らず、1Gスイッチでの代用が必要になったためです。

そこで、1G*4でLACPを組みたく方法を探しております。

セットアップ時、複数のNICがあるとお目当てのNICにAHV,CVMのNICが当たってくれないため、まず

ovs-vsctl add-bond iface br0-up eth2 # eth2の追加

ovs-vsctl del-bond iface br0-up eth0 #eth0の削除

といったコマンドで適当に調整して1NIC構成でクラスタを作成しております。

その後、PrismのNetwork設定画面からUplinkの設定をLACP Active-Activeにしたいのですが

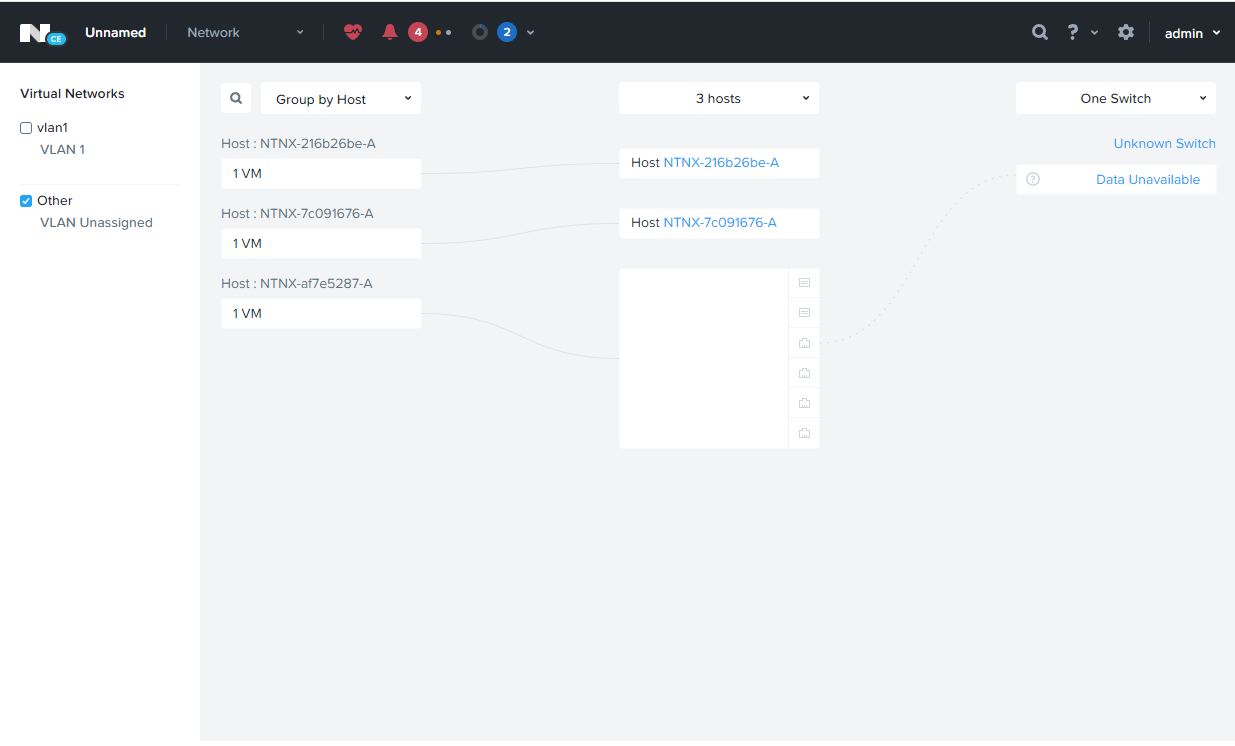

添付画像の右上にあるはずのUplink configrationボタンが見当たりません。

(もしかして、bond0-upに1NICしか追加していないからでしょうか)

3台のサーバ、微妙にNIC構成が異なっており、10G-NICが乗っていたりいなかったりするため、3台とも微妙にNICのナンバリングが異なっています。(引っこ抜けばいいのですが)

CLIでの設定でも構いませんので、bond0-upをLACPで構成する方法があれば、ご教示いただけますと幸いです。

- Trailblazer

- June 16, 2024

keroro9です。追記です。

とりあえずNICのチーミングはあきらめ仮想マシンを作成→電源ONしてみましたが

Operation failed: NoHostResources: No host has enough available resources for VM 84b54348-d9e7-4ca2-b451-845c6118de65. のメッセージでVMの起動ができませんでした。リソースは潤沢にあるはずなので何かがおかしいようです。

インストール直後(クラスタ生成前)のCVMで触ったのは、bond0-upからNICを外し、別のNICをつける工程

ovs-vsctl add-bond iface br0-up eth2 # eth2の追加

ovs-vsctl del-bond iface br0-up eth0 #eth0の削除

ovs-vsctl del-bond iface br0-up eth1 #eth1の削除

だけです。

しかし、Settings→NetworkConfigurationからInternal Interfacesを見てみるとeth0,1を利用しようとしている?ように見受けられます。不用意にbond0-upの設定をいじってしまい微妙にシステムが不安定になっているような気がしております。各サーバで増設してあるNICをいったん取り外して再セットアップしてみようかなあと考えているところです。

- Trailblazer

- June 16, 2024

keroro9です。さらに追記です。各サーバの増設したNICをすべて外し、デフォルトの1Gbps*4のみの環境にそろえて再デプロイしました。その後Settings→Network Configuration→Virtual SwitchからBond typeの変更にたどり着き、Uplink Configurationにたどり着くことができました。

詳細はわからないのですが先ほどはVirtual Switch自体が空欄になってしまっていたような気もしており、いったん「NICは全部そろえとけ」ということだけ覚えておこうかなあと思っている次第です。

- Author

- Nutanix Employee

- June 18, 2024

Bondの設定変更にたどり着けたとのこと、ご報告ありがとうございます!

後出しになってしまいますが、最初にUplink Configurationが表示されていなかった状態は、Virtual Switchが有効な状態になっていなかったのかと思います。

のドキュメントに

If there are inconsistent bond configurations across hosts before the migration of the bridges, then after the migration of bridges, the virtual switches might not be properly deployed. To resolve such issues, you must manually configure the bonds to make them consistent.

⇒ブリッジのマイグレーション前にホスト間でボンドの構成に一貫性がない場合、ブリッジのマイグレーション後に仮想スイッチが正しく配置されない可能性があります。このような問題を解決するには、ボンドを手動で構成して一貫性を持たせる必要があります。

という記載がありまして、場面としては微妙に違いますが、これと同じ状況だったのかなと。(ブリッジのマイグレーション=Virtual Switch機能の有効化)

- Trailblazer

- June 19, 2024

ちなみに世間のAzure Stack HCIではバックエンド通信のスイッチレス構成も取れますが、Nutanixではいかがでしょうか。一時期安売りしていたArubaスイッチがタッチの差で完売してしまい、しばらく10Gスイッチを入手できる見込みがなくなってしまい。うまくvSwitchの構成を組んでしまえばスイッチレスももしかして、と思った次第でした。

ネットワーク構成はさておき、早速Flowを体験したりと楽しんでおります。得られたノウハウは今後の提案に生かしていきたいと思っております。よろしくお願いいたします。

- Author

- Nutanix Employee

- June 24, 2024

Nutanixに関してはスイッチレスの直結構成はNGとなっています。

基本の構成としてはCVMの管理系通信もストレージ通信も同じ物理系等を使う(今は分割しようと思えばできますがデータローカリティの恩恵で通信帯域が輻輳しづらいのでそもそもあまりやらない)、また、Nutanixははじめから無停止でのスケールアウトを強く意識して設計されたプロダクトなので、そのあたりが犠牲になる直結は考慮していない、というあたりが背景かなと思います。

ちなみに、データローカリティがあるおかげで、Readに関しては1GbEでも結構速度が出ます。一方、Writeに関しては必ずノードまたぎの通信が発生するので10GbEにするとその恩恵が得られます。

- Trailblazer

- June 27, 2024

VMC環境の空きESXiホスト上に、NutanixCE(AHV/CVM)を1台デプロイしたのですが、

ポートグループのセキュリティポリシー(無差別モード/偽装転送)を許可設定に変更ができないため、

Prismへの疎通が不可なのですが、何かナレッジ等はお持ちでしょうか?

デプロイした仮想マシンのvNICをもう1個追加し、AHVが利用するOpen vSwitch Bridge(br0)のアップリンクのvNICと別で、新たにCVMのvnet0が利用するOpen vSwitch Bridge(br1??)を作成し、そちらのアップリンクのvNICとして割り当てれば、何とか上記制約でも利用できるのでは?と考えているのですが・・

Broadcom問題を契機に、初めてNutanixを触ってみる段階で、

ここまでカスタマイズしてNutanixを試用するのもなんですが、

もし既知ナレッジとして、何かベストな方法があればご教示いただけますと幸いです。

AHV側のIPの9440ポート宛てをiptablesのnatテーブルとip_forward有効にて、

CVM側にInternal側の192.168.5.2:9440へフォワードする方法も試してみたのですが、うまくいかず・・

- Trailblazer

- July 16, 2024

個人的には、1ノードクラスタでもいいので16コア以上、メモリは128G位の実機環境があればそれなりに評価もできるかなぁ。という感じです。上の投稿で3ノードで構築したのは、仮想マシン10台以下位なら商用並みの快適さで使えないかという意図もあります。

お求めの回答でなく申し訳ありません...。

Enter your E-mail address. We'll send you an e-mail with instructions to reset your password.

Scanning file for viruses.

Sorry, we're still checking this file's contents to make sure it's safe to download. Please try again in a few minutes.

OKThis file cannot be downloaded

Sorry, our virus scanner detected that this file isn't safe to download.

OK