Nutanix CE よろず相談所が長くなってきた&Nutanix CE 2.0 がリリースされたいい機会なので、こちらに移行したいと思います。

現在、社内のサーバにNutanix CEをiLO経由(iLOのコンソール画面でCD/DVDをマウントできるので、そこからローカルにあるNutanix CEのISOファイルをマウント)で取り込み、起動を行っておりますが、途中で止まってしまいます。

止まってしまう箇所は下記となります。

INFO Getting AOS Version from /mnt/iso/images/svm/nutanix_installer_package.tar.p00, This may take a few minites if Phoenix is running from BMC

BMC経由だと数分間時間がかかるとメッセージには出ておりますが、2時間以上経過してもこのままです。解決策をご教授していただきたいです。

備考:現在、このサーバには商用版のAOS 5.x(ライセンスは既に切れているので未使用)が入っているので、一度このクラスタを削除する必要があるのかなと思っております。

こちら、解決しました。

私も類似したトラブルでインストールが行えておりません。実施した解決策をご教示いただけますでしょうか。

Dell サーバにiDrac経由で仮想メディアをマウントしてインストールしているのですが、以下のエラーでinstallが終了している状況です。

INFO Getting AOS Version from /mnt/iso/images/svm/nutanix_installer_package.tar.p00, This may take a few minites if Phoenix is running from BMC

cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p00: Input/output error

cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p01: Input/output error

/root/phoenix/images.py の123行目で以下を実行したタイミングでのエラーかと推測しております。

shell.shell_cmd([combine_command], ttyout=True)

# ここで実行している combine_command = cat /mnt/iso/images/svm/nutanix_installer_package.tar.p0* > /mnt/svm_installer/nos.tar

試しに、上記のコマンドをssh後にホスト上で実行してみる、同様のエラーとなりました。

# cat /mnt/iso/images/svm/nutanix_installer_package.tar.p0* > /mnt/svm_installer/nos.tar cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p00: Input/output error cat: /mnt/iso/images/svm/nutanix_installer_package.tar.p01: Input/output error

また、その際のdmesgは以下のようになっています。

# dmesg | tail [ 5117.728842] Buffer I/O error on dev sr0, logical block 1, async page read [ 5117.859332] sr 11:0:0:0: [sr0] tag#0 UNKNOWN(0x2003) Result: hostbyte=0x00 driverbyte=0x08 cmd_age=0s [ 5117.859338] sr 11:0:0:0: [sr0] tag#0 Sense Key : 0x3 [current] [ 5117.859341] sr 11:0:0:0: [sr0] tag#0 ASC=0x11 ASCQ=0x0 [ 5117.859345] sr 11:0:0:0: [sr0] tag#0 CDB: opcode=0x28 28 00 00 00 00 00 00 00 02 00 [ 5117.859348] blk_update_request: critical medium error, dev sr0, sector 0 op 0x0:(READ) flags 0x0 phys_seg 2 prio class 0 [ 5117.859351] Buffer I/O error on dev sr0, logical block 0, async page read [ 5117.859354] Buffer I/O error on dev sr0, logical block 1, async page read [ 5128.216320] VFS: busy inodes on changed media sr0

以上、よろしくお願いいたします。

こちらですが、結局のところ、NWの帯域不足が原因でした。

失敗時:300GBまで帯域制限されている環境。且つ,Wi-Fi経由で通信不安定。

成功時:1GB帯域。全て有線。

私の環境も自宅からVPN経由でiDRACにアクセスしているので、安定した通信環境ではありません。

NW環境見直す or USBでインストールを試してみたいと思います。

私の環境も自宅からVPN経由でiDRACにアクセスしているので、安定した通信環境ではありません。

NW環境見直す or USBでインストールを試してみたいと思います。

VPN経由の場合、個人でWAN帯域を食いつぶさないように帯域制限かけらているはずですので、イメージのインストール失敗の原因となっていると考えられます。通信経路が全て1GB~であればおそらく問題ないはずです。USB指せるならば一番手っ取り早いです。

先日はありがとうございました。

私自身が当たったことない事象のためぱっと思いつく解決策がないく恐縮なのですが…たとえば英語フォーラムの下記こちら(https://next.nutanix.com/discussion-forum-14/trying-to-create-and-start-a-single-node-cluster-in-ce2-critical-mainthread-cluster-1430-cluster-initialization-on-x-x-x-x-failed-with-ret-false-42552/index2.html)のトピックだと、ディスクのシリアルが同一のものとして認識されてしまったことが原因で、似たような事象が発生していたようです。こちら該当してはいないでしょうか?

商用だとこういったことが起きないHWモデル/ファームウェアが必ず選定されるのですが、CEでこういった性質のHWに当たってしまうと”重複しているものを物理的に取り外す”という対応をとらざるを得ないかもしれません…。

お世話になっております。

CE2.0上に構築したPrism CentralからKarbonを利用して、k8sクラスター構築を試しています。

Storage class設定後 Createをクリックすると、「name in body should be at most 40 chars long」のエラーが表示され構築が行えません。

設定した各項目の中で40字を超えるものはないのは確認済みです。(各nameの総字数は40字を超えています)

以下のページに関連しそうなリンクがあるのですが、現在は404で閲覧ができませんでした。

https://next.nutanix.com/how-it-works-22/new-kb-articles-published-on-week-ending-may-29-2021-39622

情報をお持ちの方がいれば、ご教示いただけると幸いです。

お世話になっております。下記の件、何か解決方法がありますでしょうか?

・クラスター構成(NutanixCE2.0):

AHVを備えた 3つのノード (A、B、C)

ノード A

ノード B

ノード C に障害があります

・実行した手順:

「クラスターの拡張」新しいオプションを使用して、ノード C と同じハードウェア構成を持つ AHV をノード (ノード D) として、クラスタに追加しました。 ノード D の追加プロセスが成功しました

。 (通知と進行状況モニターで確認されました)。

ノード D がクラスター プリズム ダッシュボードに表示されます。

・問題:

クラスター Prism から「ホストの削除」を実施して、障害のあるノード C を削除しようとすると、エラーメッセージ「ノードを削除対象としてマークできません

。「ノード 20261765 はクラスターに追加されています」が表示されて、

ノード C が削除できません。ノード D はまだクラスターに追加されているとのエラーメッセージです。

CLI経由でノードCを強制的に削除しようとしましたが、同じエラーが表示されて、うまくいきませんでした。

私自身が経験したことのあるエラーではないため回答できていなかったのですが、たとえばLCMでNKE(Karbon)のバージョンを上げてからデプロイしていただくと解消する可能性はあるかと思います。

あるいは、40文字以下となっていますが、NKE(Karbon)クラスタ名をさらに短くしてみる、というのはひとつの手かと思います(社内で情報を見ていたところ17文字以下にすれば通るかもしれないという話を見かけました)。

> CLI経由でノードCを強制的に削除しようとしましたが、同じエラーが表示されて、うまくいきませんでした。

については KB-2379 にあるような ncli host rm-start コマンドをお使いでしょうか?

あるいは、コマンドリファレンスにあるようなforceオプションも付けても実行されない状況でしょうか。もしまだでしたらお試し頂くことで解消される可能性はあるかと思います。(とはいえリスクのあるオプションではあるため、悪影響の出る可能性も踏まえ自己責任でという点は何卒ご了承ください…)

お世話になっております。ご返事いただき、ありがとうございます。

> KB-2379 にあるような ncli host rm-start コマンドをお使いでしょうか?

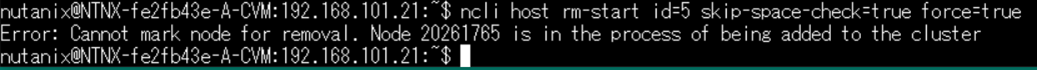

はい、ncli host rm-start コマンドでforceオプションを付けても同じエラーが出たため、削除できません。

参考までにncliコマンドのエラーメッセージの全文を(元の英文そのまま)を貼り付けていただくことは可能でしょうか?(スクショでも構いません)

有力情報を必ずしもご提供できるとは限らないのですが、社内で検索を掛けてみようと思っています。

(なにも有力情報が無かった場合は何卒ご容赦ください…)

お世話になっております。

>参考までにncliコマンドのエラーメッセージの全文を(元の英文そのまま)を貼り付けていただくことは可能でしょうか?(スクショでも構いません)

下記画像をご確認ください。エラーメッセージ本文にある「20261765」はノードDのidです。

お手数をおかけしますが、よろしくお願いいたします。

正直まだ「これだ」という答えにはたどり着けていないのですが、状態としては↓と同じような状況でしょうか(新しいノードがMetadata Ringに参加できていない)。

https://next.nutanix.com/discussion-forum-14/nutanix-ce-expand-cluster-stuck-42646

ディスクの利用率が高くない状況であれば、いったんノードCのHWを直してから1ノードクラスタとしてセットアップして、そちらにAsync DRでゲストVMを逃がしてから、A,B,Dでクラスタを組み直す、といったやり方がいちばんクリーンかもしれません。

お世話になっております。ご確認いただき、ありがとうございます。

新しいノード(ノードD)がMatadata Ringに参加できていないとのことについて、

コマンド「ncli host ls」でノードDのHost StatusがNEWであることが確認できました。

また、ノードDをMatadata Ringに参加させるコマンド「ncli host enable-metadata-store id=20261765」を実行したら、

Error: Host ad1ddd3c-7f73-49c0-9159-83d1da82c841 is not in a ready state to enable metadata store」が

表示されて、参加できません。

上記のような状況だと、ご教授いただいた方法のようにクラスタを組み直すしかないとの認識でよろしいでしょうか?

Reply

Enter your username or e-mail address. We'll send you an e-mail with instructions to reset your password.